Il Cloud Computing

Il paradigma del Cloud Computing sta trasformando il concetto di infrastruttura IT aziendale, da un modello che vede le l’IT come cost center ad un modello che rende l’infrastruttura un servizio a supporto del business. Attraverso tecnologie internet, infatti, le risorse IT (applicazioni, piattaforme e software) vengono rese disponibili in modalità scalabile ai Clienti che possono gestirle in autonomia su una rete privata e pagarle solo in base all’utilizzo. Questo consente alle imprese di avvalersi di tecnologie innovative senza doversi dotare di infrastrutture IT dedicate, con un conseguente vantaggio in termini di ottimizzazione di costi e prestazioni.

Grazie a Nuvola Italiana, un insieme sempre più ricco di infrastrutture ed applicazioni – con l’utilizzo di risorse hardware e software distribuite in remoto – viene messo a disposizione del Cliente, che può utilizzare su richiesta soluzioni e servizi senza dotarsene internamente.

Con la sua nuova proposta, Telecom Italia vuole accompagnare le imprese pubbliche e private italiane nel loro percorso verso l’innovazione digitale per favorirne la crescita e renderle competitive, collaborative e tecnologiche. E lo fa abbinando ai suoi tradizionali servizi di connettività soluzioni innovative erogate in modalità “as a service” attraverso i suoi asset tecnologici all’avanguardia:

– Data Center a copertura totale del territorio nazionale;

– reti Next Generation Network sempre più performanti e pervasive;

– un centro servizi ad alto livello di specializzazione.

Un’infrastruttura d’eccellenza che permette a Telecom Italia di proporsi tra i principali player sul mercato nazionale, con una gamma di servizi pienamente in linea con l’attuale contesto tecnologico.

L’esperienza nella gestione dei Data Center ha permesso a Telecom Italia di acquisire una profonda conoscenza nell’ambito di queste tecnologie, che sono state prima applicate e implementate per usi interni, attraverso un programma di virtualizzazione e consolidamento delle infrastrutture informatiche, e poi lanciate sul mercato in logica “as a service”. Le tecnologie di Cloud Computing infatti consentono ai Data Center di gestire una consistente quantità di risorse virtualizzate come si trattasse di un solo unico oggetto, indipendentemente da come siano state implementate, da come siano gestite e da dove risiedano.Questo permette l’erogazione di un servizio sicuro e flessibile che fornisce un insieme di infrastrutture e risorse di calcolo, di hardware, di software e di rete, in grado di ospitare le applicazioni dell’utente finale e di calcolare il pagamento dei servizi erogati in base al consumo effettivo. Un servizio che soddisfa le richieste delle imprese di affidabilità, capacità elaborative complesse, margini di rischio sempre più bassi, perché è contraddistinto da elevati standard di sicurezza, nonché da una vasta gamma di soluzioni qualificanti, quali accessi a larga banda per la connettività, assistenza e Customer Care, supporto tecnico, monitoraggio e gestione H24 dei sistemi ospitati.

Un’offerta così completa garantisce al cliente tre diversi tipi di vantaggi:

Strategici: consentendo all’azienda di concentrarsi sulle attività caratterizzanti il proprio core business ed eliminando la componente di rischio sulle scelte tecnologiche

Economici: ottimizzando i costi fissi, grazie a una minimizzazione dell’investimento in capacità infrastrutturale non utilizzata, a una drastica diminuzione del personale dedicato e a una struttura di pricing modulare

Tecnologici: grazie a tecnologie all’avanguardia, e continuamente aggiornate che garantiscono una gestione end-to-end centralizzata e un’elevata protezione dei dati sia logica che fisica.

La crisi dei software\Software crisis

Il software crisis è un termine usato nei primi giorni dell’ingegneria del software per descrivere l’impatto della rapida crescita della potenza degli elaboratori e la complessità dei problemi che dovevano essere affrontati. Le parole chiave della software crisis erano complessità, attese e cambiamento.

I requisiti, continuamente in conflitto tra loro, impedivano lo sviluppo del software. Per esempio, mentre gli utenti domandavano un largo numero di funzionalità, i committenti, generalmente, chiedevano di minimizzare i costi dello sviluppo ed i tempi.

Il concetto di software crisis era emerso alla fine del 1960. Un vecchio uso del termine era in ACM Turing Award Lecture, “The Humble Programmer” (EWD340), di Edsger Dijkstra del 1972 pubblicato in Communications of the ACM.

Dijkstra affermava: “The major cause of the software crisis is that the machines have become several orders of magnitude more powerful! To put it quite bluntly: as long as there were no machines, programming was no problem at all; when we had a few weak computers, programming became a mild problem, and now we have gigantic computers, programming has become an equally gigantic problem” Edsger Dijkstra: The Humble Programmer (PDF, 473Kb).

Le cause della software crisis era collegate alla complessità dei processi software ed alla relativa immaturità dell’ingegneria del software. La crisi si manifestava in diversi modi:

- Progetti oltre il budget

- Progetti oltre i limiti di tempo

- Software di scarsa qualità

- Software che spesso non rispettava i requisiti

- Progetti ingestibili e codice difficile da manutenere

La crisi del software condusse, quindi, alla nascita dell’Ingegneria del software ed ai primi modelli, come il modello a cascata.

Per superare la crisi, infatti, si dovettero introdurre:

Management

Organizzazione

Teorie e Tecniche

Strumenti

Metodologie

– Wikipedia, l’enciclopedia libera.

———————————————————————————————————————————-

Il termine “crisi del software” è stato coniato nei primi anni ’70, quando l’ingegneria del software era praticamente inesistente. Il termine esprime le difficoltà di sviluppo software nel soddisfare la rapida crescita della domanda di software, la complessità dei problemi da risolvere e l’assenza di tecniche consolidate per sviluppare sistemi che funzionano correttamente o che possono essere convalidate.

La percezione che questa crisi è stato avviato a metà degli anni ’60. Uno dei primi riferimenti alla parola, e più in particolare, è stata fatta da EWDijkstra, nel suo discorso durante il Turing Award nel 1972.

In questo lavoro prenderemo in considerazione che questa crisi si è verificato, e qual è stato il percorso intrapreso per risolvere o minimizzare i loro effetti in qualche modo.

Le cause della crisi del software:

Durante la fine degli anni ’50 primi anni ’60 i, la potenza di calcolo delle macchine era piuttosto limitata. Questo è il motivo per programmi che sono stati sviluppati erano “semplici” dal nostro punto di vista. A seguire un processo di sviluppo piuttosto tradizionale, non una metodologia o una via da seguire per lo sviluppo. Questo tempo viene utilizzato per utilizzare i linguaggi di basso livello per lo sviluppo software.

Ma negli anni ’60, il potere delle macchine hanno cominciato ad aumentare in modo significativo. Lingue cominciarono ad apparire programmazione ad alto livello, e le macchine necessarie programmi molto più complessi elaborati fino a quel momento. In breve, è stato un salto enorme in termini di potenziale di hardware, che non è stato accompagnato da un salto nello sviluppo del software.

In questo momento, hanno cominciato a concepire il software come prodotto, e hanno cominciato a sviluppare alcuni progetti che hanno lavorato sulle macchine del tempo.Ma i problemi principali apparsi: i prodotti hanno superato la stima dei costi era ritardi nelle consegne, i benefici non sono stati richiesti, la manutenzione è diventato estremamente difficile e talvolta impossibile, le modifiche erano proibitivi … insomma, è un software sviluppato scarsa qualità, dal momento che la tecnica utilizzata per sviluppare piccoli programmi per macchine con meno potenziale è stata superata, e spesso questo software aveva dimenticato. A titolo di esempio, si può vedere il grafico del 1979, che riflette l’investimento nello sviluppo di software di sistema che l’anno ($ 6,8 milioni), e come il software chiuso

Fonte: Note di gestione Software Engineering. “Tema 1: Software e Ingegneria del Software”

Una delle principali cause di questo, se non l’obiettivo principale è stato dato al processo di sviluppo del software, che era male e, a volte era inesistente. In questo processo, solo ¼ del tempo di sviluppo è stata dedicata alle fasi di analisi, progettazione, codifica e test, e più di ¾ del tempo è stato dedicato alla correzione e manutenzione. Chiaramente dom ¼ dedicare tempo alle prime fasi, eseguire la scansione errori, soprattutto dalla fase di analisi e progettazione, che ha notevolmente ostacolato la realizzazione, la produzione si ferma e inverte costanti di rivedere l’analisi / design.

Per darci, idea tutta fasi di analisi e progettazione di copertura 8% del tempo totale di sviluppo software. Inoltre circa il 80% di errori avvenuto in due fasi, per cui il costo è aumentato correzione di errore secondo evoluto fasi così bestiali. Con questi indicatori era chiaro che qualcosa stava fallendo e che il processo di sviluppo del software aveva bisogno di un cambiamento radicale.

-http://histinf.blogs.upv.es/2011/01/04/la-crisis-del-software/

Arduino

-Arduino is an open-source electronics prototyping platform based on flexible, easy-to-use hardware and software. It’s intended for artists, designers, hobbyists, and anyone interested in creating interactive objects or environments.

Arduino can sense the environment by receiving input from a variety of sensors and can affect its surroundings by controlling lights, motors, and other actuators. The microcontroller on the board is programmed using the Arduino programming language (based on Wiring) and the Arduino development environment (based on Processing). Arduino projects can be stand-alone or they can communicate with software running on a computer (e.g. Flash, Processing, MaxMSP).

The boards can be built by hand or purchased preassembled; the software can be downloaded for free. The hardware reference designs (CAD files) are available under an open-source license, you are free to adapt them to your needs.

Arduino received an Honorary Mention in the Digital Communities section of the 2006 Ars Electronica Prix. The Arduino team is: Massimo Banzi, David Cuartielles, Tom Igoe, Gianluca Martino, and David Mellis.-

-Sito officiale Arduino

Arduino è un framework open source che permette la prototipazione rapida e l’apprendimento veloce dei principi fondamentali dell’elettronica e della programmazione. È composto da una piattaforma hardware per il physical computing sviluppata presso l’Interaction Design Institute, un istituto di formazione post-dottorale con sede a Ivrea, fondato da Olivetti e Telecom Italia. Il nome della scheda deriva da quello di un bar di Ivrea (che richiama a sua volta il nome di Arduino d’Ivrea, Re d’Italia nel 1002) frequentato da alcuni dei fondatori del progetto.

Questa si basa su un circuito stampato che integra un microcontrollore con pin connessi alle porte I/O, un regolatore di tensione e quando necessario un’interfaccia USB che permette la comunicazione con il computer. A questo hardware viene affiancato un ambiente di sviluppo integrato (IDE) multipiattaforma (per Linux, Apple Macintosh e Windows). Questo software permette anche ai novizi di scrivere programmi con un linguaggio semplice e intuitivo derivato da C e C++ chiamato Wiring, liberamente scaricabile e modificabile.

Arduino può essere utilizzato per lo sviluppo di oggetti interattivi stand-alone ma può anche interagire, tramite collegamento, con software residenti su computer, come Adobe Flash, Processing, Max/MSP, Pure Data, SuperCollider, Vvvv.

La piattaforma hardware Arduino è spesso distribuita agli hobbisti in versione pre-assemblata, acquistabile in internet o in negozi specializzati. La particolarità del progetto è che le informazioni sull’hardware e soprattutto i progetti sono disponibili per chiunque: si tratta quindi di un hardware open source, distribuito nei termini della licenza Creative Commons Attribution-ShareAlike 2.5. In questo modo, chi lo desideri può legalmente auto-costruirsi un clone di Arduino o derivarne una versione modificata, scaricando gratuitamente lo schema elettrico e l’elenco dei componenti elettronici necessari. Questa possibilità ha consentito lo sviluppo di prodotti Arduino compatibili da parte di piccole e medie aziende in tutto il mondo, e infatti oggi è possibile scegliere tra un’enorme quantità di schede Arduino compatibili. Ciò che accomuna questi prodotti inerenti elettronica sperimentale e sviluppo è il codice sorgente per l’ambiente di sviluppo integrato e la libreria residente che sono resi disponibili, e concessi in uso, secondo i termini legali di una licenza libera, GPLv2.

Grazie alla base software comune, ideata dai creatori del progetto, per la comunità Arduino è stato possibile sviluppare programmi per connettere a questo hardware più o meno qualsiasi oggetto elettronico, computer, sensori, display o attuatori. Dopo anni di sperimentazione è oggi possibile fruire di un database di informazioni vastissimo.

Il team di Arduino è composto da Massimo Banzi, David Cuartielles, Tom Igoe, Gianluca Martino, e David Mellis. Il progetto prese avvio in Italia a Ivrea nel 2005, con lo scopo di rendere disponibile, a progetti di Interaction design realizzati da studenti, un dispositivo per il controllo che fosse più economico rispetto ai sistemi di prototipazione allora disponibili. I progettisti riuscirono a creare una piattaforma di semplice utilizzo ma che, al tempo stesso, permetteva una significativa riduzione dei costi rispetto ad altri prodotti disponibili sul mercato. A ottobre 2008 in tutto il mondo erano già stati venduti più di 50.000 esemplari di Arduino.

-Wikipedia

Arduino nasce nel 2005 come strumento di prototipazione elettronica per i miei studenti quando insegnavo all’Interaction Design Institute di Ivrea.

Nel 2001 la Olivetti e la Telecom Italia avevano creato questo istituto per attivare un master biennale di Interaction Design: per la prima volta nel mondo si apriva una scuola dedicata unicamente a questa disciplina.

Uno dei principali aspetti dell’insegnamento ad Ivrea era quello di fornire agli studenti le basi essenziali di elettronica necessarie per potersi costruire prototipi veramente funzionanti.

La filosofia dell’insegnamento e di conseguenza di quello che si pensava sarebbe dovuto essere la professione di interaction designer era infatti sviluppata attraverso una metodologia basata molto sulla sperimentazione pratica e, in parallelo, sulla creazione di prototipi funzionanti da sperimentare, testare, provare con gli utenti degli oggetti per verificarne reazioni e sensazioni. Quindi, nessuna astrazione, ma molta pratica e manualità.

Al mio arrivo all’istituto, pochi mesi dopo la sua apertura, avevo notato che gli studenti avevano iniziato ad utilizzare una piattaforma americana nota come “Basic Stamp”, una delle prime a rendere più accessibile l’uso dei microcontrollori. Lavorando sui primi progetti divennero chiari i principali difetti della Basic Stamp: si rivelò, infatti, molto meno potente di altri prodotti sul mercato e funzionava solo con Windows. Inoltre, l’importazione dagli Stati Uniti la rendeva piuttosto costosa – 76 EUR – per un oggetto che gli studenti avrebbero dovuto acquistare in quantità per poter realizzare il maggior numero possibile di prototipi.

E quindi, subito l’anno successivo mi misi al lavoro per trovare un’alternativa che fosse basata su un microcontrollore commerciale e più economico, un software open source che funzionasse anche su Mac OS X (il sistema operativo utilizzato dalla maggior parte degli studenti di design).

Dopo molte sperimentazioni ho realizzato la scheda “Programma 2003” (in onore della Olivetti Programma 101, da molti considerato il primo personal computer della storia) e con quello abbiamo realizzato molti progetti poi messi in mostra in tutto il mondo.

Dopo quella esperienza mi sono accorto che comunque continuavano a esserci una serie di problemi: innanzitutto, la scheda utilizzava un linguaggio di programmazione (JAL) non molto sofisticato e diverso dal linguaggio con cui gli studenti imparavano a programmare (Processing). Inoltre, la mancanza di una comunità all’esterno dell’istituto limitava pesantemente la possibilità di crescita della piattaforma.

In quel momento ho iniziato a discuterne alternative e possibilità con alcuni colleghi professori, come Bill Verplank (Il mio maestro ed esperto di Interaction Design dell’università di Stanford) che mi ha indirizzato su un tipo di processore diverso (AVR) che veniva usato anche a Stanford, e con Casey Reas, uno degli inventori di Processing, che mi ha convinto che la soluzione migliore sarebbe stata quella di cercare di creare una versione di Processing funzionante anche sui piccoli processori come l’AVR.

L’anno successivo – era quindi il 2003 – abbiamo messo al lavoro uno studente (H. Barragan) sotto la nostra supervisione ed abbiamo creato la piattaforma Wiring con la quale è stato creato il linguaggio che ancora oggi usiamo con Arduino.

Nonostante questo passaggio fondamentale non ero ancora soddisfatto perché la scheda Wiring, essendo dotata di un processore molto potente, costava comunque 70/80 EUR ed era di complessa fabbricazione e che, quindi, doveva essere prodotta in un’azienda.

Nel frattempo chiesi all’istituto di incaricare Gianluca Martino di realizzare alcune schede Wiring per testare la nuova piattaforma sugli studenti. I risultati furono ottimi confermando che le nostre idee iniziali erano giuste. Venne il momento di portare i progetti realizzati durante il corso a una mostra da realizzarsi a Torino nel gennaio 2005, Strangely Familiar presso l’AB+. Era l’occasione di realizzare una scheda che rendesse più facile costruire nuovi prototipi.

L’idea che mi ronzava in testa era quella di creare una scheda davvero semplice che, volendo, si potesse realizzare in casa e che costasse 20 EUR.

Il prezzo derivava dal fatto che una buona cena in giro per Ivrea costava all’epoca quella cifra: mi piaceva quindi l’idea che uno studente potesse rinunciare a una cena per comprarsi una scheda in più.

In quel periodo David Cuartielles, professore all’Università di Malmö, era ospite ad Ivrea per un progetto di ricerca e cominciammo a discutere insieme delle mie idee. Gli feci vedere un prototipo del circuito che avevo costruito (che allora si chiamava ancora Programma 2005); David trovò subito un errore e lo riparò dando il primo contributo fattivo al progetto. Da lì in poi iniziammo a dare forma alle nostre intuizioni. Il progetto accelerò considerevolmente. Lavorando principalmente alla sera al di fuori dall’orario di lavoro, disegnammo la forma attuale della scheda. Per la parte software chiedemmo a uno studente americano, David Mellis, di aiutarci a re-implementare tutto da zero con l’idea di renderlo completamente open source.

Una notte, mentre lavoravamo alacremente per finire i prototipi da portare alla mostra, io e David chiedemmo a Mellis quanto ci volesse secondo lui a re-implementare il linguaggio di Wiring sul processore più piccolo e limitato della nascente Arduino. Rispose che in un paio d’ore avrebbe potuto darci qualcosa di funzionante. In effetti verso l’1 di notte ricevetti per mail i files e potei testarli sul primo progetto degli studenti. Dopo una serie di martellamenti funzionò tutto… A questo punto, con l’aiuto di un altro studente, Nicolas Zambetti, ripulimmo il codice e lo adattammo all’ambiente di sviluppo di Wiring per permettere agli studenti di utilizzare il loro codice Wiring per scrivere programmi sulla nuova scheda.

A questo punto io e David Cuartielles decidemmo di investire un migliaio di euro per far produrre 600 circuiti stampati di Arduino con l’idea di regalarli in giro per convincere la gente ad adottare la nuova piattaforma.

Proprio nel momento in cui dovevamo inviare i files alla fabbrica per la produzione della scheda ci accorgemmo che non aveva un proprio nome che fosse davvero nostro (in precedenza la scheda si chiamava P2005 oppure Wiring Lite). Dopo molte discussioni e la telefonata perentoria del produttore che ci minacciava “o mi mandate i files entro un’ora o non li avrete mai per la data che mi avete richiesto”, io proposi, con l’idea che avremmo sempre fatto in tempo a cambiarlo, il nome “molto Eporediese” di Arduino, come il bar dove andavamo a bere l’aperitivo.

Alla fine il nome Arduino ci è piaciuto davvero e l’abbiamo mantenuto. Da lì è iniziata la nostra operazione di proselitismo: decidemmo infatti di pubblicare subito tutta la documentazione su internet compresi anche i files CAD dei circuiti elettronici in modo che altre persone potessero produrre delle schede senza il nostro intervento. Questo rese Arduino uno dei primi progetti al mondo che fossero open source sia nel software sia nell’hardware.

Nel giugno del 2005 Tom Igoe entrò nel team dopo un progetto realizzato assieme ad Ivrea e divenne il nostro ambasciatore negli USA adottando la piattaforma all’ITP di New York.

Arduino divenne un prodotto utilizzabile da tutti dal settembre del 2005 quando Gianluca investì dei soldi suoi per produrre le prime 200 Arduino “Professionali”. Infine, quando nel novembre del 2005, organizzammo il primo workshop pubblico a Londra e riuscimmo a raccogliere 25 iscritti, ci rendemmo conto che qualcosa si era messo in moto e che la comunità stava iniziando a funzionare.

John Von Neumann

John von Neumann, nato János Neumann (Budapest, 28 dicembre 1903 – Washington, 8 febbraio 1957), è stato un matematico e informatico ungherese naturalizzato statunitense.

Fu una delle personalità scientifiche preminenti del XX secolo cui si devono fondamentali contributi in campi come teoria degli insiemi, analisi funzionale, topologia, fisica quantistica, economia, informatica, teoria dei giochi, fluidodinamica e in molti altri settori della matematica.

John von Neumann è stato una delle menti più brillanti e straordinarie del secolo scorso. Insieme a Leo Szilard, Edward Teller ed Eugene Wigner, i quattro facevano parte del “clan degli ungheresi” ai tempi di Los Alamos e del Progetto Manhattan. Oltre ad essere ungheresi, tutti e quattro erano di origini ebraiche ed erano stati costretti a rifugiarsi negli USA per sfuggire alle persecuzioni naziste.

Le sue capacità hanno permesso a Neumann di apportare contributi significativi e spesso assolutamente innovativi in molti campi della ricerca, dalla matematica alla meccanica statistica, dalla meccanica quantistica alla cibernetica, dall’economia all’evoluzione biologica, dalla teoria dei giochi all’intelligenza artificiale.

Quello di von Neumann con i militari è stato un rapporto piuttosto stretto, alimentato dalle sue convinzioni anti-naziste prima e anti-comuniste poi, sfociate in un vero e proprio odio che lo porterà ai vertici delle istituzioni politico militari degli Stati Uniti come membro del potente Comitato per i missili balistici intercontinentali.

Johnny, come lo chiamavano i suoi colleghi americani, era anche un grande amante della vita, e accanto alla personalità geniale ma cinica e spietata conviveva, apparentemente senza contraddizione alcuna, l’altro volto dello scienziato ungherese, quello affabile, mai presuntuoso, simpatico e goliardico.

Attorno alla sua figura sono state scritte molte storie che hanno caratterizzato nell’eccesso questo personaggio, gran parte delle quali, però, dettate da ostilità e avversione nei confronti del suo pensiero politico e sociale.

Tra il 1930 e il 1933 viene invitato a Princeton, dove mette in luce una vena didattica non proprio esemplare; la sua grande fluidità di pensiero mette in difficoltà molti degli studenti, che sono costretti a seguire i calcoli su una piccola porzione di lavagna che lo scienziato cancella poi velocemente impedendo agli allievi di copiare le equazioni. Nel 1933 apre i battenti l’Institute for Advanced Study, sempre a Princeton, e von Neumann è uno dei sei professori originari di matematica insieme a Albert Einstein, Hermann Weyl, Morse, Alexander e Thorstein Veblen.

Poco dopo, con l’arrivo dei nazisti al potere, abbandona la sua posizione accademica in Germania, considerando l’avventura americana ben più promettente. Terrà la cattedra di Princeton fino alla fine dei suoi giorni.

Negli anni successivi, von Neumann dà sfoggio del suo enorme talento nel campo della ricerca e si interessa dei problemi legati alla turbolenza idrodinamica e quindi alla risoluzione delle equazioni differenziali non lineari, che gli serviranno come stimolo per studiare nuove possibilità legate alla computazione elettronica.

Ma a rendere famoso e amato Johnny è anche l’altro lato della sua personalità, quello allegro e gioviale, che lo rende particolarmente abile nell’organizzare e animare le feste. I suoi party sono famosi, numerosi e piuttosto lunghi e sa intrattenere amabilmente gli ospiti con un repertorio vastissimo di barzellette e storielle, naturalmente in molte lingue.

Durante la Seconda guerra mondiale crea la teoria dei giochi pubblicando nel 1944, insieme a Oskar Morgenstern, un testo che diverrà un classico, Theory of Games and Economic Behavior.

Alcuni anni più tardi Shannon, uno dei padri fondatori della teoria dell’informazione, si baserà sui lavori di von Neumann per pubblicare il suo articolo Una macchina giocatrice di scacchi.

Sempre nel 1944, von Neumann viene a conoscenza da un suo collega, Herman Goldstine, impegnato anch’esso nel Progetto Manhattan, dei tentativi effettuati presso il laboratorio balistico di costruire una macchina capace di trecento operazioni al secondo. Von Neumann rimane profondamente colpito da questa cosa e dentro alla sua mente si aprono nuovi e affascinanti scenari.

Il primo incontro con un calcolatore risale a poco tempo dopo, con la macchina Harvard Mark I (ASCC) di Howard Aiken, costruita in collaborazione con l’IBM; poi conosce ENIAC (Electronic Numerical Integrator And Computer) presso il Ballistic Research Laboratory, un ammasso enorme di valvole, condensatori e interruttori da trenta tonnellate di peso, costruita da Prosper Eckert e John Mauchly.

Questo primordiale computer è utile per eseguire calcoli balistici, meteorologici o sulle reazioni nucleari, ma è una macchina limitata, quasi del tutto priva di memoria e di elasticità, che può eseguire solo operazioni predeterminate. Per migliorarla bisogna utilizzare l’intuizione che aveva avuto Alan Turing una decina d’anni prima nel suo articolo sui numeri computabili[senza fonte] , e cioè permettere al computer (l’hardware) di eseguire le istruzioni codificate in un programma (software) inseribile e modificabile dall’esterno. Nel 1945 esce così First Draft of a Report on the Edvac.

L’EDVAC (Electronic Discrete Variables Automatic Computer) è la prima macchina digitale programmabile tramite un software basata su quella che sarà poi definita l’architettura di von Neumann. Il merito dell’invenzione, oltre che allo scienziato ungherese, va ad Alan Turing (per l’idea: l’EDVAC, a dispetto della propria memoria finita, è la realizzazione della macchina universale inventata da Turing nel 1936, ovvero, un computer programmabile nel senso moderno del termine) e ad Eckert e Mauchly (per la realizzazione).

Gli anni della guerra vedono von Neumann coinvolto nel Progetto Manhattan per la costruzione della bomba atomica; è un coinvolgimento alimentato da un profondo odio verso i nazisti, i giapponesi e successivamente verso i sovietici. Già nel 1937, dopo aver ottenuto la cittadinanza statunitense, gli viene proposto di collaborare con le forze armate e da quel momento la sua escalation ai vertici delle istituzioni politico-militari non conoscerà più soste. È lui a suggerire come deve essere lanciata la bomba atomica per creare il maggior numero di danni e di morti, è lui che interviene nella costruzione della bomba al plutonio realizzando la cosiddetta “lente al plutonio”, ed è ancora lui a incentivare la costruzione di ordigni nucleari sempre più potenti. Ma si spinge oltre, proponendo alle autorità militari di bombardare preventivamente l’Unione Sovietica per scongiurare il pericolo rosso. La sua teoria dei giochi viene utilizzata in questo contesto per studiare e ipotizzare tutti i possibili scenari bellici che si possono sviluppare in seguito a certe decisioni. Il fervore con cui appoggia lo sviluppo degli ordigni atomici lo spinge a seguire di persona alcuni test sulle armi nucleari nella seconda metà degli anni quaranta, che raggiungeranno l’apice con l’esplosione della bomba H nelle Isole Marshall nel 1952. Probabilmente saranno proprio le radiazioni sprigionate da questi test a condannarlo a morte [1], da lì a poco.

Nello stesso anno dell’esplosione della bomba H, viene nominato membro del General Advisory Committee della AEC (Atomic Energy Commission) e consigliere della CIA (Central Intelligence Agency, l’agenzia statunitense per lo spionaggio all’estero). Tre anni più tardi diventa membro effettivo dell’AEC.

Nel pieno della Guerra Fredda, a metà degli anni Cinquanta, si impegna al massimo per appoggiare la costruzione del missile balistico intercontinentale (ICBM) Atlas che, successivamente modificato, servirà per le missioni spaziali, portando John Glenn nello spazio nel 1962.

Un tumore alle ossa lo costringe sulla sedia a rotelle, anche se la malattia non gli impedisce di seguire di persona le riunioni strategiche con i militari, mentre si dedica a nuovi studi che riguardano programmi capaci di autoriprodursi e che lui chiama automi cellulari.

Confortato da pochi amici che gli saranno vicini fino all’ultimo, come Wigner, muore l’8 febbraio del 1957.

§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§§

John von Neumann ( /vɒn ˈnɔɪmən/; December 28, 1903 – February 8, 1957) was a Hungarian-American mathematician and polymath who made major contributions to a vast number of fields,[1] including mathematics (set theory, functional analysis, ergodic theory, geometry, numerical analysis, and many other mathematical fields), physics (quantum mechanics, hydrodynamics, and fluid dynamics), economics (game theory), computer science (linear programming, computer architecture, self-replicating machines, stochastic computing), and statistics. He is generally regarded as one of the greatest mathematicians in modern history.[2]

The mathematician Jean Dieudonné called von Neumann “the last of the great mathematicians”,[3] while Peter Lax described him as possessing the most “fearsome technical prowess” and “scintillating intellect” of the century,[4] and Hans Bethe stated “I have sometimes wondered whether a brain like von Neumann’s does not indicate a species superior to that of man”.[5] He was born in Budapest around the same time as Theodore von Kármán (b. 1881), George de Hevesy (b. 1885), Leó Szilárd (b. 1898), Eugene Wigner (b. 1902), Edward Teller (b. 1908), and Paul Erdős (b. 1913).[6]

Von Neumann was a pioneer of the application of operator theory to quantum mechanics, in the development of functional analysis, a principal member of the Manhattan Project and the Institute for Advanced Study in Princeton (as one of the few originally appointed), and a key figure in the development of game theory[1][7] and the concepts of cellular automata,[1] the universal constructor, and the digital computer. Von Neumann’s mathematical analysis of the structure of self-replication preceded the discovery of the structure of DNA.[8] In a short list of facts about his life he submitted to the National Academy of Sciences, he stated “The part of my work I consider most essential is that on quantum mechanics, which developed in Göttingen in 1926, and subsequently in Berlin in 1927–1929. Also, my work on various forms of operator theory, Berlin 1930 and Princeton 1935–1939; on the ergodic theorem, Princeton, 1931–1932.” Along with Teller and Stanisław Ulam, von Neumann worked out key steps in the nuclear physics involved in thermonuclear reactions and the hydrogen bomb.

Von Neumann wrote 150 published papers in his life; 60 in pure mathematics, 20 in physics, and 60 in applied mathematics. His last work, an unfinished manuscript written while in the hospital and later published in book form as The Computer and the Brain, gives an indication of the direction of his interests at the time of his death.

Il test (o articolo) di Turing

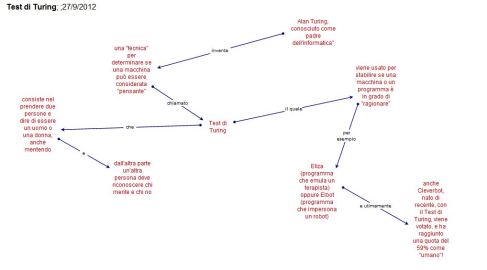

Nell’articolo Turing prende spunto da un gioco, chiamato “gioco dell’imitazione”, a tre partecipanti: un uomo A, una donna B, e una terza persona C. Quest’ultimo è tenuto separato dagli altri due e tramite una serie di domande deve stabilire qual è l’uomo e quale la donna. Dal canto loro anche A e B hanno dei compiti: A deve ingannare C e portarlo a fare un’identificazione errata, mentre B deve aiutarlo. Affinché C non possa disporre di alcun indizio (come l’analisi della grafia o della voce), le risposte alle domande di C devono essere dattiloscritte o similarmente trasmesse.

Il test di Turing si basa sul presupposto che una macchina si sostituisca ad A. Se la percentuale di volte in cui C indovina chi sia l’uomo e chi la donna è simile prima e dopo la sostituzione di A con la macchina, allora la macchina stessa dovrebbe essere considerata intelligente, dal momento che – in questa situazione – sarebbe indistinguibile da un essere umano.

Per macchina intelligente Turing ne intende una in grado di pensare, ossia capace di concatenare idee e di esprimerle. Per Turing, quindi, tutto si limita alla produzione di espressioni non prive di significato. Nell’articolo, riprendendo il “Cogito” cartesiano, si legge: Secondo la forma più estrema di questa opinione, il solo modo per cui si potrebbe essere sicuri che una macchina pensa è quello di essere la macchina stessa e sentire se si stesse pensando. […] Allo stesso modo, la sola via per sapere che un uomo pensa è quello di essere quell’uomo in particolare. […] Probabilmente A crederà “A pensa, mentre B no”, mentre per B è l’esatto opposto “B pensa, ma A no”. Invece di discutere in continuazione su questo punto, è normale attenersi alla educata convenzione che ognuno pensi.

Le macchine di Turing sono macchine a stati finiti in grado di simulare altre macchine a stati discreti. Una macchina per sostenere il test dev’essere programmata considerando la descrizione di un uomo in termini discreti (stati interni, segnali, simboli). Dalla complessità del software, si legge tra le righe dell’articolo, emergeranno le funzioni intellettuali. Su questa aspettativa si fonda una disciplina nota come intelligenza artificiale il cui scopo è la costruzione di una macchina in grado di riprodurre le funzioni cognitive umane.

Ricerca su Alan Mathison Turing

Alan Mathison Turing (Londra, 23 giugno 1912 – Wilmslow, 7 giugno 1954) è stato un matematico, logico e crittografo britannico, ed è considerato uno dei padri dell’informatica, un brillate crittoanalista e uno dei più grandi matematici del ventesimo secolo. Operò nell’esercito britannico durante la WW2 per aiutare gli Alleati contro le potenti forze dell’Asse. Morì a 41 anni, probabilmente suicida; si pensa per colpa delle perseguitazioni da parte degli inglesi stessi per colpa della sua omosessualità.

Turing venne concepito in India, durante uno dei frequenti viaggi di suo padre, Julius Mathison Turing, membro del Indian Civil Service. Sia Julius sia sua moglie, Ethel Sara Stoney, madre del futuro Alan Turing, decisero tuttavia che il piccolo dovesse nascere sul suolo inglese. Tornarono quindi a Londra dove il 23 Giugno 1912 nacque Alan Mathison Turing. Già fin dalla più tenera età diede segno della genialità che negli anni futuri lo renderà famoso in tutto il mondo; tuttavia a seguito della sua enorme passione per le materie scientifiche divenne inviso ai professori del St. Michael, la sua prima scuola, i quali avevano sempre posto più enfasi agli studi classici. Durante i primi anni di scuola ebbe quindi grosse difficoltà, ottenendo il diploma a stento. Poco appassionato al latino e alla religione, preferiva letture riguardanti la teoria della relatività, i calcoli astronomici, la chimica o il gioco degli scacchi. Nel 1931 venne ammesso al King’s College dell’Università di Cambridge dove approfondì i suoi studi sulla meccanica quantistica, la logica e la teoria della probabilità (dimostrò separatamente il teorema del limite centrale, già dimostrato nel 1922 dal matematico Lindeberg). Nel 1934 si laureò con il massimo dei voti e nel 1936 vinse il premio Smith (riconoscimento che veniva assegnato ai due migliori studenti ricercatori in Fisica e Matematica presso l’Università di Cambridge). Nello stesso anno si trasferì alla Princeton University dove studiò per due anni, ottenendo infine un Ph.D. In questi anni pubblicò l’articolo “On computable Number, with an application to the Entscheidungsproblem” dove descriveva, per la prima volta, quella che sarebbe poi stata definita come la macchina di Turing.

Durante la seconda guerra mondiale, Turing mise le sue capacità matematiche al servizio del Department of Communications inglese per decifrare i codici usati nelle comunicazioni tedesche, criptate tramite il cosiddetto sistema Enigma (progettato da Arthur Scherbius). Con l’entrata in guerra dell’Inghilterra Turing fu “arruolato” nel gruppo di crittografi stabilitosi a Bletchley Park e con i suoi compagni lavorò stabilmente, per tutta la durata della guerra, alla decrittazione, sviluppando le ricerche già svolte dall’Ufficio Cifra polacco con la macchina Bomba, progettata in Polonia da Marian Rejewski nel 1932 e ultimata nel 1938. Basandosi su tali esperienze Turing realizzò una nuova versione, molto più efficace, della bomba di Rejewski. Fu sul concetto di macchina di Turing che nel 1942 il matematico di Bletchley Park, Max Newman progettò una macchina chiamata Colossus (lontana antesignana dei computer) che decifrava in modo veloce ed efficiente i codici tedeschi creati con la cifratrice Lorenz SZ40/42, perfezionamento della cifratrice Enigma.

Al termine della guerra Turing fu invitato al National Physical Laboratory (NPL, Laboratorio Nazionale di Fisica) a Londra per disegnare il modello di un computer. Il suo rapporto che proponeva l’Automatic Computing Engine (ACE, Motore per il Calcolo Automatico) fu presentato nel marzo 1946, ma ebbe scarso successo a causa degli alti costi preventivati. Bisogna inoltre sottolineare che l’attività di Alan Turing nel gruppo di Bletchley Park fu coperta dal segreto più assoluto. Finita la guerra il governo inglese impose a tutti coloro che avevano lavorato alla decrittazione, realizzando macchine e sistemi per violare i codici crittografici tedeschi, giapponesi e italiani, il divieto di parlare o, ancor peggio, scrivere di qualsiasi argomento trattato in quel periodo. Tale “silenzio” quindi impedì che Turing, come altri suoi colleghi anche meno famosi, ricevesse i riconoscimenti in campo scientifico che in altro ambito gli sarebbero stati ampiamente e pubblicamente riconosciuti. Dati e informazioni su queste attività cominciarono a essere pubblicate, previa autorizzazione dei servizi segreti inglesi, solo nel 1974, quando Turing e molti altri suoi colleghi nella decrittazione erano già defunti da tempo.

Per l’anno accademico 1947/48 tornò a Cambridge e spostò i suoi interessi verso la neurologia e la fisiologia. Fu in questo periodo che iniziò a esplorare la relazione tra i computer e la natura. Ebbe anche interessi al di fuori dell’ambito accademico: divenne membro del Walton Athletic Club e vinse alcune gare di corsa sulle tre e dieci miglia. Raggiunse inoltre ottimi livelli nella maratona, correndo con un record personale di 2 ore 46 minuti e 11 secondi (il vincitore della XIV Olimpiade nel 1948 vinse con un tempo inferiore di soli 11 minuti).

Nel 1950 scrisse un articolo dal titolo Computing machinery and intelligence sulla rivista Mind in cui descriveva quello che sarebbe divenuto noto come il test di Turing: su questo articolo si basa buona parte dei successivi studi sull’intelligenza artificiale.

L’anno seguente fu eletto Membro della Royal Society di Londra. Si trasferì all’Università di Manchester, dove lavorò alla realizzazione del Manchester Automatica Digital Machine (MADAM). Convinto che entro l’anno 2000 sarebbero state create delle macchine in grado di replicare la mente umana, lavorò alacremente creando algoritmi e programmi per il MADAM, partecipò alla stesura del manuale operativo e ne divenne uno dei principali fruitori. Nel 1952 sviluppò un approccio matematico all’embriologia. Il 31 marzo dello stesso anno fu arrestato per omosessualità e condotto in giudizio, dove a sua difesa disse semplicemente che «… non scorgeva niente di male nelle sue azioni». Secondo alcune fonti Turing avrebbe denunciato per furto un amico ospite in casa sua e ammesso il proprio orientamento sessuale in risposta a delle domande pressanti della polizia. In quel periodo si dibatteva nel parlamento britannico l’abrogazione del reato di omosessualità e ciò probabilmente avrebbe indotto Turing a un comportamento incauto. La pena inflitta fu severissima: fu sottoposto alla castrazione chimica, che lo rese impotente e gli causò lo sviluppo del seno; alcuni dei motivi che probabilmente lo condussero, di lì a poco, al suicidio. Secondo altri Turing sarebbe stato indotto al suicidio dagli stessi servizi di intelligence inglesi.

Nel 1954 Alan Turing morì ingerendo una mela avvelenata con cianuro di potassio, in tono col proprio carattere eccentrico e prendendo spunto dalla fiaba di Biancaneve da lui apprezzata fin da bambino. La madre sostenne che il figlio, con le dita sporche per qualche esperimento chimico, avesse ingerito per errore la dose fatale di veleno; ma il verdetto ufficiale parlò senza incertezze di suicidio: «Causa del decesso: cianuro di potassio autosomministrato in un momento di squilibrio mentale».

Eeeeeed ecco il mio primo post.

Si, questo è il mio primo post… Ed è anche molto triste, non so che scrivere.